55

模型选择:选择估计量及其参数

分数和交叉验证分数

如我们所见,每一个估计量都有一个可以在新数据上判定拟合质量(或预期值)的 score 方法。越大越好.

1 | from sklearn import datasets, svm |

为了更好地预测精度(我们可以用它作为模型的拟合优度代理),我们可以连续分解用于我们训练和测试用的 折叠数据。

1 | import numpy as np |

这被称为 KFold 交叉验证.

交叉验证生成器

scikit-learn 有可以生成训练/测试索引列表的类,可用于流行的交叉验证策略。

类提供了 split 方法,方法允许输入能被分解的数据集,并为每次选择的交叉验证策略迭代生成训练/测试集索引。

下面是使用 split 方法的示例。

1 | from sklearn.model_selection import KFold, cross_val_score |

然后就可以很容易地执行交叉验证了:

1 | [svc.fit(X_digits[train], y_digits[train]).score(X_digits[test], y_digits[test]) |

交叉验证分数可以使用 cross_val_score 直接计算出来。给定一个估计量,交叉验证对象,和输入数据集, cross_val_score 函数就会反复分解出训练和测试集的数据,然后使用训练集和为每次迭代交叉验证运算出的基于测试集的分数来训练估计量。

默认情况下,估计器的 score 方法被用于运算个体分数。

可以参考 metrics 模块 学习更多可用的评分方法。

1 | cross_val_score(svc, X_digits, y_digits, cv=k_fold, n_jobs=-1) |

n_jobs=-1 意味着运算会被调度到所有 CPU 上进行。

或者,可以提供 scoring 参数来指定替换的评分方法。

1 | cross_val_score(svc, X_digits, y_digits, cv=k_fold, |

交叉验证生成器

| 调用 | 功能 |

|---|---|

KFold (n_splits, shuffle, random_state) |

将其分解为 K 个折叠,在 K-1 上训练,然后排除测试。 |

StratifiedKFold (n_splits, shuffle, random_state) |

和 K-Fold 一样,但会保留每个折叠里的类分布。 |

GroupKFold (n_splits) |

确保相同组不会在测试和训练集里。 |

ShuffleSplit (n_splits, test_size, train_size, random_state) |

生成基于随机排列的训练/测试索引。 |

StratifiedShuffleSplit |

和 shuffle 分解一样,但会保留每个迭代里的类分布。 |

GroupShuffleSplit |

确保相同组不会在测试和训练集里。 |

LeaveOneGroupOut () |

使用数组分组来给观察分组。 |

LeavePGroupsOut (n_groups) |

忽略 P 组。 |

LeaveOneOut () |

忽略一个观察。 |

LeavePOut (p) |

忽略 P 观察。 |

PredefinedSplit |

生成基于预定义分解的训练/测试索引。 |

练习

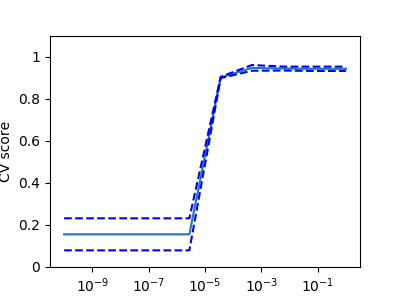

在数字数据集中,用一个线性内核绘制一个

SVC估计器的交叉验证分数来作为C参数函数(使用从1到10的点对数网格).

2

3

4

5

6

7

8

from sklearn.model_selection import cross_val_score

from sklearn import datasets, svm

digits = datasets.load_digits()

X = digits.data

y = digits.target

svc = svm.SVC(kernel='linear')

C_s = np.logspace(-10, 0, 10)

网格搜索和交叉验证估计量

网格搜索

scikit-learn 提供了一个对象,在给定数据情况下,在一个参数网格,估计器拟合期间计算分数,并选择参数来最大化交叉验证分数。这个对象在构建过程中获取估计器并提供一个估计器 API。

1 | from sklearn.model_selection import GridSearchCV, cross_val_score |

默认情况下, GridSearchCV 使用一个三倍折叠交叉验证。但是,如果它检测到分类器被传递,而不是回归,它就会使用分层的三倍。

嵌套交叉验证

2

3

array([ 0.938..., 0.963..., 0.944...])两个交叉验证循环并行执行:一个由

GridSearchCV估计器设置gamma,另一个cross_val_score则是测量估计器的预期执行情况。结果分数是对新数据上的预期分数的无偏估计。

警告

你不可以并行运算嵌套对象(n_jobs不为1)。

交叉验证估计量

设置参数的交叉验证可以更有效地完成一个基础算法。这就是为什么对某些估计量来说,scikit-learn 提供了 交叉验证 估计量自动设置它们的参数。

1 | from sklearn import linear_model, datasets |

这些估计量和它们的副本称呼类似,在名字后加 ‘CV’。

练习

在糖尿病数据集中,找到最优正则化参数 α。

另外: 你有多相信 α 的选择?

2

3

4

5

6

from sklearn.linear_model import LassoCV

from sklearn.linear_model import Lasso

from sklearn.model_selection import KFold

from sklearn.model_selection import GridSearchCV

diabetes = datasets.load_diabetes()