Transformer

文章

入门教程

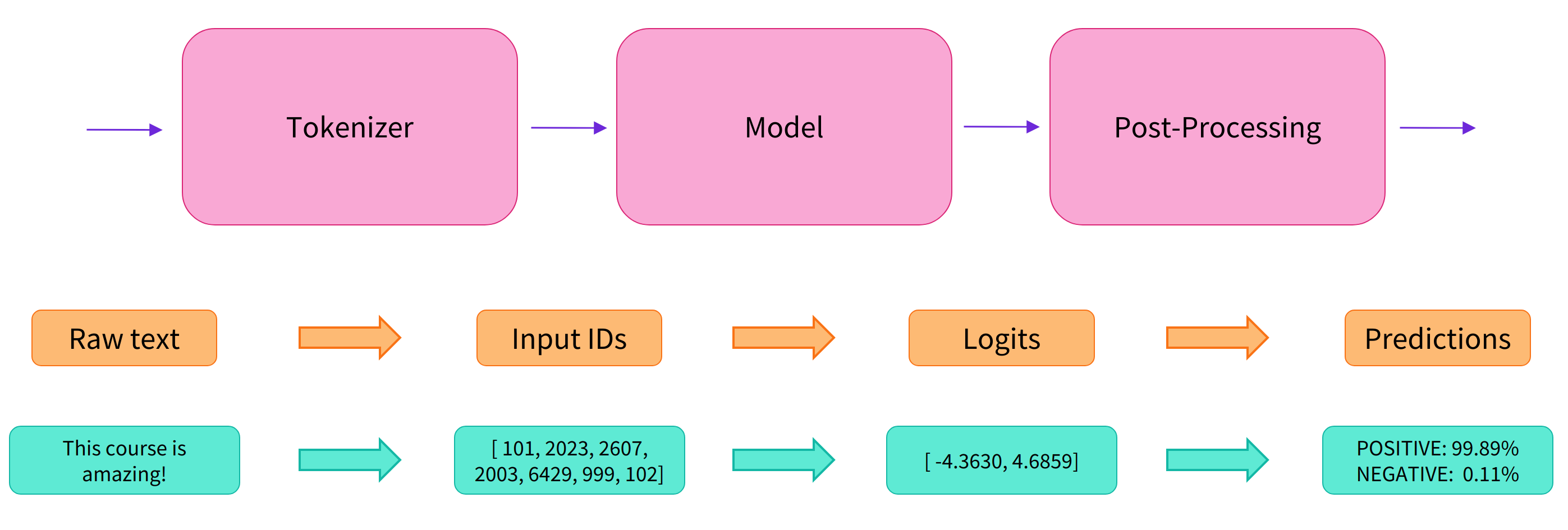

transofrmers最简单的说明 参考文档https://transformers.run/c2/2021-12-08-transformers-note-1/https://fancyerii.github.io/2021/05/11/huggingface-transformers-1/#%E7%AE%80%E4%BB%8B官方文档https://huggingface.co/docs/transformers/v4.36.1/zh/index 是什么目前各种Pretraining的Transformer模型层出不穷,虽然这些模型都有开源代码,但是它们的实现各不相同,我们在对比不同模型时也会很麻烦。Huggingface Transformer能够帮我们跟踪流行的新模型,并且提供统一的代码风格来使用BERT、XLNet和GPT等等各种不同的模型。 基本原则huggingface的transfomers工具库,只有configuration,models和tokenizer三个主要类。所有的模型都可以通过统一的from_pretrained()函数来实现加载,transf...

evaluate教程

https://blog.csdn.net/muyao987/article/details/125411129 安装1pip install evaluate 检查是否安装成功 12python -c "import evaluate; print(evaluate.load('accuracy').compute(references=[1], predictions=[1]))" load加载评估指标 evaluate中的每个指标都是一个单独的Python模块,通过 evaluate.load()(点击查看文档) 函数快速加载,其中load函数的常用参数如下: path:必选,str类型。可以是指标名(如 accuracy 或 社区的铁汁们贡献 的 muyaostudio/myeval),如果源码安装还可以是路径名(如./metrics/rouge 或 ./metrics/rogue/rouge.py)。我用的后者,因为直接传指标名会联网下载评价脚本,但单位的网不给力。...

PEFT教程

说明参数高效微调(PEFT)方法在微调过程中冻结预训练模型的参数,并在其顶部添加少量可训练参数(adapters)。adapters被训练以学习特定任务的信息。这种方法已被证明非常节省内存,同时具有较低的计算使用量,同时产生与完全微调模型相当的结果。 使用安装12pip install peft 加载adapter要从huggingface的Transformers库中加载并使用PEFTadapter模型,请确保Hub仓库或本地目录包含一个adapter_config.json文件和adapter权重,如上例所示。然后,您可以使用AutoModelFor类加载PEFT adapter模型。例如,要为因果语言建模加载一个PEFT adapter模型: 指定PEFT模型id将其传递给AutoModelForCausalLM类 1234from transformers import AutoModelForCausalLM, AutoTokenizerpeft_model_id = "ybelkada/opt-350m-lora"model = AutoModel...